- Raul Silva

- 10 de jan.

- 9 min de leitura

Atualizado: 10 de jan.

A máquina de fake news do século XXI: Deepfakes crescem 830% no Brasil e ameaçam integridade Eleitoral em 2026

Geração de vídeos realistas por IA a custo zero, combinada com plataformas generativas, criou ferramentas perfeitas para fabricação de narrativas políticas falsas. Enquanto regulação avança, capacidade de detecção falha e beneficiários da desinformação lucram com impunidade.

Da Redação d`O estopim Tech | 10 de janeiro de 2026

Em setembro de 2024, no bairro Monte Sinai em Manaus, moradores receberam em redes sociais uma publicação impactante: um trecho de telejornalismo do Jornal Nacional onde o apresentador William Bonner recomendava voto em um candidato local a vereador. O problema: o vídeo era totalmente falso, gerado por inteligência artificial.

Casos como esse multiplicam-se pelo Brasil. Entre 2024 e janeiro de 2026, deepfakes—conteúdos gerados ou manipulados por IA para substituir rostos, vozes e corpos em vídeos—cresceram 830% em um ano. Enquanto isso, ferramentas cada vez mais sofisticadas de geração de conteúdo sintético (como Sora do OpenAI e Veo 3 do Google) democratizaram a produção de desinformação: qualquer pessoa com um computador pode, em minutos, criar narrativas falsas hiperrealistas praticamente indistinguíveis da verdade.

A tecnologia que prometia eficiência tornou-se a arma mais refinada da desordem democrática. E enquanto o Estado responde com legislação, quem se beneficia da incapacidade de distinguir verdade de ficção gerada por máquina continua operando com impunidade.

830%: o crescimento vertiginoso da fraude digital

Em 2023, a Sumsub (empresa de verificação de identidade) publicou seu Identity Fraud Report, analisando 2 milhões de tentativas de fraude em 224 países. O Brasil apresentou um fenômeno singular: enquanto a América do Norte registrava aumento de 1.740% em deepfakes e a América Latina média de 410%, o Brasil disparava isoladamente com 830% de crescimento.

Contextualizando: enquanto a Espanha enfrentava o maior volume absoluto de deepfakes do mundo (um em cada dez ataques globais ocorre lá), o Brasil superava todos os demais países latino-americanos juntos em incidentes dessa natureza.

Mais recente ainda: entre 2023 e 2024, deepfakes envolvendo abuso infantil explodiram de 4,7 mil para 67 mil casos—um aumento de 1.325%. Crianças reais tiveram seus rostos inseridos em conteúdo sexual gerado por IA. Em escolas brasileiras, pelo menos 16 casos de deepfakes sexuais foram identificados em 10 estados entre 2024 e 2025.

Mas os números mais perturbadores não estão apenas em estatísticas globais. Estão em operações do crime organizado. Um grupo com 46 mil membros no Brasil foi mapeado em 2024 comercializando deepfakes de celebridades brasileiras por valores entre R$ 19,90 e R$ 25—industrializando a criação de desinformação.

De ferramentas de entretenimento a armas políticas

Até 2023, deepfakes eram principalmente curiosidade: vídeos de celebridades em situações absurdas, montagens humorísticas. A técnica era complexa, cara e necessitava de expertise. Mudou drasticamente quando OpenAI, Google, Meta e outras gigantes lançaram ferramentas de geração de vídeo acessíveis, baratas ou gratuitas.

Em dezembro de 2024, OpenAI anunciou Sora, um modelo capaz de gerar vídeos com até um minuto de duração, com qualidade cinematográfica, a partir de um texto simples. Praticamente simultâneo, Google lançou Veo 3. Essas ferramentas não demandam conhecimento de programação. Um clique, um prompt em linguagem natural, e em minutos: um vídeo fake pronto para viralizar.

A democratização da desinformação ocorreu em velocidade exponencial.

Durante as eleições municipais de 2024 no Brasil, o Observatório IA Nas Eleições—parceria entre Data Privacy Brasil, Aláfia Lab e Desinformante mapeou 78 casos de materiais confirmados ou alegadamente criados por meio de IA. Mas esse número subestima a realidade.

Casos emblemáticos:

Em São Paulo, o candidato Pablo Marçal (PRTB) postou uma deepfake sem sinalizar o uso de IA, como exige a resolução do TSE. No vídeo, um rosto é trocado pelo de Marçal e a pessoa assopra pó branco uma referência a acusações infundadas contra rival.

Em Salvador, o prefeito reeleito Bruno Reis (União) postou vídeos nos quais seu rosto é adicionado ao corpo de um homem que dança o jingle da campanha. No Instagram, veio com aviso "feito com IA." No TikTok, nenhuma advertência.

Em Manaus, como mencionado, William Bonner apareceu em deepfake recomendando voto em vereador.

Havia ainda deepnudes imagens com teor sexual gerado por IA. Candidatas em Rio de Janeiro e Bauru (SP) registraram boletins de ocorrência após serem alvo de deepfakes pornográficos postados em redes sociais e sites de conteúdo adulto.

Google, Meta e a perversão da "IA Democrática"

Enquanto candidatos usavam IA para criar conteúdo falso, as próprias gigantes de tecnologia continuavam alimentando a máquina de desinformação.

Em setembro de 2024, o Jornal da Paraíba revelou que o Gemini, IA do Google, continuava fornecendo informações sobre candidatos à prefeitura de João Pessoa, apesar das promessas públicas do Google em restringir respostas políticas pela ferramenta.

O Gemini também havia gerado informações sobre candidatos à prefeitura de São Paulo: Ricardo Nudes (MDB), Pablo Marçal (PRTB), José Luiz Datena (PSDB) e Marina Helena (Novo).

A Meta, por sua vez, usou chatbots e algoritmos de recomendação que amplificavam conteúdo desinformativo. Enquanto isso, investigadores sugerem que a empresa monitora remoção de conteúdo de forma lenta e defasada, deixando deepfakes circularem por horas ou dias antes de ação.

O padrão é claro: essas plataformas ganham com desinformação (quanto mais polêmica, mais engajamento; quanto mais engagement, mais publicidade vendida), enquanto externamente celebram investimentos em "segurança eleitoral."

A regulação que não consegue acompanhar a tecnologia

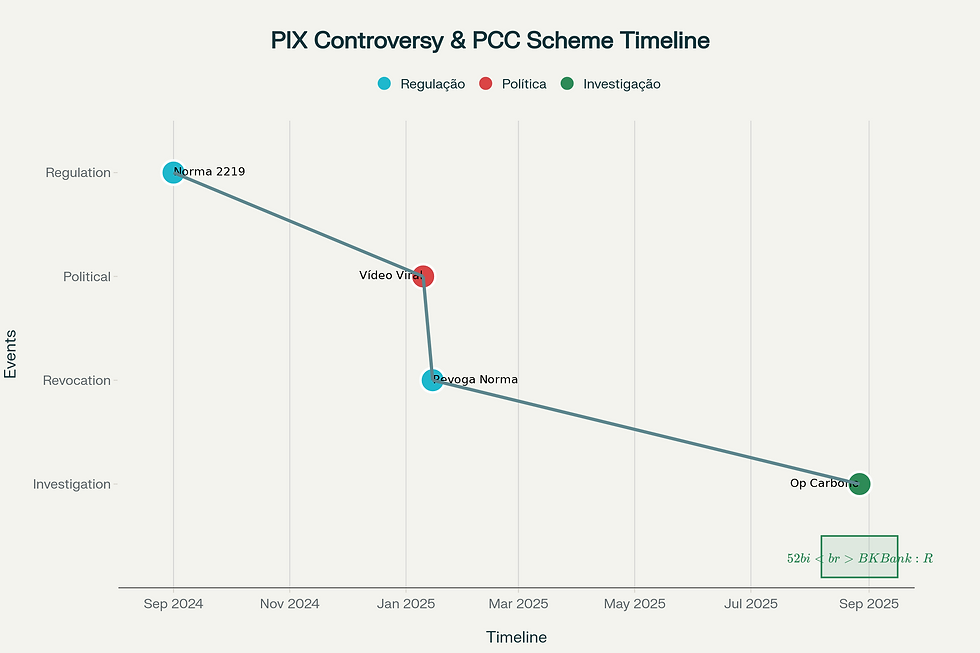

Reconhecendo o risco, o Tribunal Superior Eleitoral (TSE) editou a Resolução nº 23.732/2024, que alterou regulações de propaganda eleitoral.

As principais inovações:

Proibição absoluta de deepfakes usados em propaganda eleitoral

Obrigação de aviso explícito quando qualquer conteúdo sintético é usado

Responsabilização de big techs: plataformas que não removem conteúdo desinformativo "imediatamente" podem sofrer sanções

Criação de repositório de decisões do TSE para agilizar processos de remoção

O presidente do TSE, ministro Alexandre de Moraes, chamou a resolução de "uma das normas mais modernas do mundo" com relação ao combate a desinformação.

Mas a realidade jurídica revelou-se complexa. Um estudo do Instituto de Direito Público (IDP), em parceria com Ethics4AI e Mackenzie, analisou 56 decisões de Tribunais Regionais Eleitorais envolvendo possíveis deepfakes. O achado alarmante: em 25% dos casos, os juízes nem consideraram que se tratava de conteúdo eleitoral.

Juízes, frequentemente sem expertise em tecnologia, classificavam conteúdos desinformativos como "discurso político legítimo"—não como fraude eleitoral.

Além disso, a Resolução TSE funciona primordialmente para conteúdo visível em plataformas públicas. Mas a maioria dos deepfakes circula em grupos privados de WhatsApp, Telegram e Discord—ambientes onde moderação é praticamente inexistente e plataformas argumentam não ter responsabilidade.

O PL 2338: ambição regulatória encontra realidade tecnológica

Em paralelo, o Projeto de Lei 2338/2023 (Marco Legal da IA) foi aprovado pelo Senado e tramita na Câmara dos Deputados.

O PL segue modelo similar ao AI Act da União Europeia, classificando sistemas de IA em níveis de risco: excessivo (proibido), alto (requisitos rigorosos), médio e baixo.

Especificamente para deepfakes, o PL inclui proteção contra deepfakes de imagens íntimas não consentidas, responsabilidade de desenvolvedores de sistemas de IA, e cláusulas de proteção à liberdade de expressão (sátira e paródia permanecem).

Mas há problema crítico: o PL responsabiliza desenvolvedores de IA, não usuários ou distribuidores. Um criminoso que baixa um programa gratuito de deepfake, cria conteúdo falso e o distribui não é diretamente responsabilizado.

É como responsabilizar fabricantes de faca por crimes de faca—útil em alguns casos, insuficiente em outros.

Além disso, o PL ainda não foi aprovado. A lacuna regulatória permanece aberta enquanto tecnologias evoluem.

Detecção vs. Geração: uma corrida que a defesa está perdendo

Aqui emerge um paradoxo fundamental: a mesma tecnologia que permite criar deepfakes é usada para detectá-los.

No Brasil, laboratórios como o recod.ai da Unicamp (200 pesquisadores no campus, 350 colaboradores globais) desenvolvem algoritmos que analisam pistas invisíveis ao olho humano—iluminação, sombras, textura da pele, ruídos digitais—para diferenciar vídeos reais de sintéticos.

O coordenador do recod.ai, Anderson Rocha, descreve uma "corrida de gato e rato": conforme pesquisadores criam detector novo, outro grupo cria gerador melhor para escapar da detecção.

O problema é assimétrico: criadores de deepfakes demandam minutos. Detectores demandam análise longa. Distribuidores de conteúdo não têm incentivo para fazer análise automaticamente.

Além disso, modelos de detecção frequentemente falham com diversidade. Se treinados principalmente com rostos brancos e jovens, falham detectando deepfakes de pessoas mais velhas ou de outras etnias.

Instituições públicas como TSE, STF e Polícia Federal têm ferramentas de detecção, mas com capacidade limitada, especialmente para conteúdo em ambientes privados.

O Mercado Criminoso da Desinformação: quem lucra?

A comercialização de deepfakes alcançou escala industrial. Um grupo com 46 mil membros—mapeado pela SaferNet em 2024—vendia deepfakes de celebridades brasileiras por preços acessíveis.

Esses grupos operam em Dark Web, Telegram e plataformas criptografadas.

Mas quem lucra mais não são microempreendedores de deepfakes. São:

Big Techs: Google, Meta, Amazon e Microsoft lucram com publicidade enquanto plataformas amplificam conteúdo desinformativo. Algoritmos são otimizados para engajamento, não para verdade. Desinformação gera mais engajamento.

Candidatos e partidos políticos: 85 candidatos declararam gastos com empresas que fornecem conteúdos gerados por IA, sendo que ao menos 38 publicaram conteúdos sintéticos sem avisar ao eleitor.

Criminosos organizados: Fraudes por deepfake crescem. Golpistas usam áudio de CEO para convencer funcionário a fazer transferência bancária. Usam rostos falsos para abrir contas em fintechs. Entre janeiro e julho de 2025, 1,242 milhão de tentativas de fraude por deepfake foram registradas só na Serasa Experian.

Atores geopolíticos: Análise de especialistas sugere que agências de inteligência estrangeira experimentam com deepfakes em eleições de países rivais.

Quem NÃO lucra: democracia, confiança pública, eleitores que votam baseados em informações falsas.

Um especialista em cibersegurança alertou: "A probabilidade de um criminoso digital sendo pego ainda é baixa. É muito mais vantajoso para um cibercriminoso estando no Brasil cometer crimes, inclusive fora do país."

A incerteza jurídica como campo fértil para Desinformação

Um fenômeno paralelo ocorre nas cortes: disputas judiciais sobre responsabilidade de plataformas deixam vácuo temporal onde desinformação prospera sem risco significativo de remoção.

Em 2024, o Supremo Tribunal Federal declarou o artigo 19 do Marco Civil da Internet parcialmente inconstitucional, aumentando responsabilidade de plataformas por conteúdo de terceiros.

Mas houve oito embargos de declaração (recursos judiciais). A incerteza jurídica resultante significa que big techs não fazem investimentos robustos em moderação, argumentando estar à espera de clareza legal.

Esse "compasso de espera favorece justamente aqueles que se beneficiam da disseminação de desinformação."

Para 2026, quando ocorrem eleições presidenciais, essa incerteza jurídica é particularmente danosa. Especialistas temem que deepfakes se proliferem ainda mais porque nem plataformas nem autoridades têm linhas claras de ação.

2026: o laboratório eleitoral aprimorado

As eleições municipais de 2024 foram chamadas de "laboratório" por especialistas.

Os testes indicaram: (1) deepfakes funcionam para manipular narrativas; (2) regulação TSE tem lacunas; (3) detecção é insuficiente; (4) distribuição em apps privados é incontrolável; (5) população tem dificuldade em identificar conteúdo falso.

Para 2026, o cenário é mais ameaçador. Presidenciais implicam apostas mais altas. Polarização é extrema. Tecnologia evoluiu (Sora, Veo 3). Criminosos têm 16 meses para aprimorar técnicas.

Um relatório da R7 em dezembro de 2025 alertou: "Ataques com deepfake crescem 126% em 2025; materiais gerados por IA forjam rostos, vozes e vídeos."

O especialista Antônio Netto enfatizou: "O deepfake tem potencial de convencimento muito maior que conteúdo genérico IA. Um vídeo alterado para colocar palavras na boca de um político é exatamente o que deepfake se propõe fazer: simular realidade e potencialmente enganar."

A verdade como Produto Raro

A raiz do problema não está na tecnologia. Está na economia política da desinformação.

Quem se beneficia quando população não consegue distinguir verdade? Narrativa política conveniente mas falsa. Candidato cuja mensagem é ampliada mesmo sendo desinformativa. Plataforma que lucra com cliques de conteúdo polarizador. Ator geopolítico que quer desestabilizar democracia rival.

Para todos esses agentes, verdade é custo, não benefício.

Um pesquisador da área resumiu: "Modelos de negócio de redes sociais instrumentalizam emoções. Verdade é chata. Falsidade sensacionalista vira viral."

A solução proposta por educadores é "letramento em IA"—ensinar população a reconhecer sinais de síntese. Mas isso é trabalho de longa duração (anos), e tecnologia evolui em meses.

Enquanto isso, desinformação não espera por alfabetização. Ela se propaga, influencia voto, corrói confiança em instituições.

Iniciativas de contra-ataque: Unicamp, TSE e limites da resistência

Não há inação completa. A Unicamp criou ferramentas usadas pela Polícia Federal para detectar pornografia infantil. O TRE-GO desenvolveu GuaIA, um projeto de IA para monitorar automaticamente desinformação em redes sociais sobre eleições estaduais.

A UERJ e UNICAMP desenvolveram Vota AI, ferramenta que analisa programas de governo (ao menos 60 mil).

Mas iniciativas acadêmicas e judiciais enfrentam desafios:

Recursos limitados: Universidades e cortes eleitorais têm orçamentos reduzidos comparado ao investimento de big techs

Velocidade da evolução: Modelo de detecção de 2024 pode ser obsoleto em 2025

Ambientes privados: Ferramentas funcionam em conteúdo público; WhatsApp, Telegram e Discord são praticamente invulneráveis

Expertise limitada: Número reduzido de especialistas em deepfake detection no Brasil

A arquitetura da impunidade

A máquina de fake news do século XXI não existe por acaso. É produto de:

Tecnologia acessível: Ferramentas generativas baratas/gratuitas

Incentivos perversos: Plataformas lucram com engajamento, não com verdade

Lacunas regulatórias: Lei atrasa tecnologia; criminalidade avança

Ambientes incontroláveis: Mensageria privada escapa de moderação

Assimetria de poder: Criadores de deepfakes operam rapidamente; detectores são lentos

Beneficiários: Candidatos, plataformas, criminosos, atores geopolíticos—todos ganham quando democracia desconfiar de sua própria vista

A pergunta que fica para 2026 é: conseguirá o Brasil estabelecer defesa robusta contra desinformação sintetizada antes que eleição presidencial seja contaminada por narrativas indistinguíveis de realidade?

Ou continuaremos em um mundo onde a verdade é privada de quem pode produzir ficção convincente a custo zero?

Essa não é mais questão tecnológica. É questão política.

8.png)